Amerykańska firma internetowa BrightPlanet opublikowała raport, w którym stwierdza, że zasoby Internetu są co najmniej pięćset razy większe, niż wynikało z dotychczasowych szacunków

Potwierdzono zatem dość powszechne wśród specjalistów i analityków przekonanie o istnieniu nie zbadanych obszarów sieci. Funkcjonowało nawet do tej pory pojęcie "niewidzialna sieć", jednak nikt przed BrightPlanet nie odważył się oszacować jej wielkości i nie próbował analizować, dlaczego pewna część Internetu pozostaje w ukryciu. Publikując swoje dane, amerykańska firma ukuła nowy termin - sieć głęboka (deep Web) - określający obszary pozostające pod powierzchnią internetowego oceanu, o których istnieniu zwykli użytkownicy nawet nie wiedzą.

Według autorów raportu, popularne przeszukiwarki sieciowe, jak AltaVista czy Lycos, tylko prześlizgują się po powierzchni Internetu. Wiele korzystających z nich osób jest rozczarowanych. "Dzisiaj przeszukiwarki internetowe przypominają nieco pogodę, bowiem wszyscy na nie narzekają" - stwierdził Danny Sullivan, wydawca sieciowego serwisu Search-EngineWatch.com, zajmującego się analizowaniem i porównywaniem funkcjonowania systemów przeszukujących Internet.

Do tego, by opisać, w jaki sposób pracownicy BrightPlanet odkryli i zmierzyli głębie Internetu, trzeba przypomnieć, w jaki sposób przeszukuje się standardowo powierzchnię sieci. Służą do tego specjalne programy przeszukujące (search engines), z których najbardziej znane są HotBot i AltaVista. Są one ogromnymi bazami danych pełnymi odnośników do stron WWW. Zbiory te są gromadzone i uaktualniane w następujący sposób: odpowiednie oprogramowanie sprawdza non stop adresy i odnośniki wszystkich istniejących na serwerach WWW stron internetowych. Każdy adres jest indeksowany w bazie danych. Kiedy użytkownik łączy się z przeszukiwarką i wpisuje szukane hasło, program wysyła w odpowiedzi adresy stron WWW, w których pojawiło się żądane słowo. Posiadając odpowiednio szybkie komputery i sprawnie napisane programy wyszukujące, można więc teoretycznie zindeksować wszystkie istniejące w danym momencie strony WWW. Kłopot jednak polega na tym, że nie wszystkie informacje dostępne w sieci istnieją w postaci gotowych czy też - jak to się określa w komputerowym żargonie - statycznych dokumentów.

Wiele dużych serwisów WWW, mieszczących miliony informacji, funkcjonuje w formie baz danych zawierających surowe informacje. Można je bez kłopotu uzyskać, wysyłając bezpośrednie zapytanie ze strony głównej takiego serwisu (np. jaka jest pogoda w Gwatemali). Otrzymamy wtedy wyczerpującą odpowiedź w formie strony WWW. Tyle że istnienie jej jest jednorazowe i przeszukiwarki jej nie rejestrują. Dla AltaVisty czy HotBota strony takiej zatem po prostu nie ma. W rezultacie nie ma jej również dla użytkownika sieci, który chce zebrać informacje, korzystając wyłącznie z ulubionej przeszukiwarki.

Dotychczas określało się pojemność sieci na podstawie wspólnego zbioru wszystkich stron zindeksowanych i zapamiętanych przez najważniejsze przeszukiwarki. Szacowano, że sieciowych dokumentów jest około miliarda. Firma BrightPlanet, dzięki oprogramowaniu LexiBot, sięgnęła w głąb Internetu, do serwisów generujących na bieżąco strony z informacjami. W wyniku tych czasochłonnych poszukiwań okazało się, że dokumenty sieciowe możemy liczyć w setkach miliardów. Równie duża jest różnica między liczbą dokumentów odkrywanych przez przeszukiwarki, a tych, które są ukryte w największych serwisach "głębokiej sieci". Autorzy raportu twierdzą, że na 60 największych serwisach "głębokiej sieci" (np. NASA czy Terraserver) zgromadzono prawie czterdzieści razy więcej informacji, niż znajduje się w całym "naskórkowym" Internecie.

Podawane przez BrightPlanet przybliżone szacunki dotyczące rozmiarów "głębokiej sieci" są oszałamiające, ale nie liczba ukrytych stron jest w tym wypadku najważniejsza. Istotniejszy jest fakt, że te zasoby są o wiele wartościowsze niż archiwa "naskórkowego" Internetu. Wynika to z faktu, że o wiele trudniej jest skonstruować serwis WWW generujący dynamiczne witryny, niż stworzyć statyczne strony WWW. Na budowę takich witryn stać jedynie największych - instytucje rządowe, uniwersytety, najbogatsze firmy. A ci z reguły dbają bardzo o wysoki poziom informacji.

Według autorów raportu, popularne przeszukiwarki sieciowe, jak AltaVista czy Lycos, tylko prześlizgują się po powierzchni Internetu. Wiele korzystających z nich osób jest rozczarowanych. "Dzisiaj przeszukiwarki internetowe przypominają nieco pogodę, bowiem wszyscy na nie narzekają" - stwierdził Danny Sullivan, wydawca sieciowego serwisu Search-EngineWatch.com, zajmującego się analizowaniem i porównywaniem funkcjonowania systemów przeszukujących Internet.

Do tego, by opisać, w jaki sposób pracownicy BrightPlanet odkryli i zmierzyli głębie Internetu, trzeba przypomnieć, w jaki sposób przeszukuje się standardowo powierzchnię sieci. Służą do tego specjalne programy przeszukujące (search engines), z których najbardziej znane są HotBot i AltaVista. Są one ogromnymi bazami danych pełnymi odnośników do stron WWW. Zbiory te są gromadzone i uaktualniane w następujący sposób: odpowiednie oprogramowanie sprawdza non stop adresy i odnośniki wszystkich istniejących na serwerach WWW stron internetowych. Każdy adres jest indeksowany w bazie danych. Kiedy użytkownik łączy się z przeszukiwarką i wpisuje szukane hasło, program wysyła w odpowiedzi adresy stron WWW, w których pojawiło się żądane słowo. Posiadając odpowiednio szybkie komputery i sprawnie napisane programy wyszukujące, można więc teoretycznie zindeksować wszystkie istniejące w danym momencie strony WWW. Kłopot jednak polega na tym, że nie wszystkie informacje dostępne w sieci istnieją w postaci gotowych czy też - jak to się określa w komputerowym żargonie - statycznych dokumentów.

Wiele dużych serwisów WWW, mieszczących miliony informacji, funkcjonuje w formie baz danych zawierających surowe informacje. Można je bez kłopotu uzyskać, wysyłając bezpośrednie zapytanie ze strony głównej takiego serwisu (np. jaka jest pogoda w Gwatemali). Otrzymamy wtedy wyczerpującą odpowiedź w formie strony WWW. Tyle że istnienie jej jest jednorazowe i przeszukiwarki jej nie rejestrują. Dla AltaVisty czy HotBota strony takiej zatem po prostu nie ma. W rezultacie nie ma jej również dla użytkownika sieci, który chce zebrać informacje, korzystając wyłącznie z ulubionej przeszukiwarki.

Dotychczas określało się pojemność sieci na podstawie wspólnego zbioru wszystkich stron zindeksowanych i zapamiętanych przez najważniejsze przeszukiwarki. Szacowano, że sieciowych dokumentów jest około miliarda. Firma BrightPlanet, dzięki oprogramowaniu LexiBot, sięgnęła w głąb Internetu, do serwisów generujących na bieżąco strony z informacjami. W wyniku tych czasochłonnych poszukiwań okazało się, że dokumenty sieciowe możemy liczyć w setkach miliardów. Równie duża jest różnica między liczbą dokumentów odkrywanych przez przeszukiwarki, a tych, które są ukryte w największych serwisach "głębokiej sieci". Autorzy raportu twierdzą, że na 60 największych serwisach "głębokiej sieci" (np. NASA czy Terraserver) zgromadzono prawie czterdzieści razy więcej informacji, niż znajduje się w całym "naskórkowym" Internecie.

Podawane przez BrightPlanet przybliżone szacunki dotyczące rozmiarów "głębokiej sieci" są oszałamiające, ale nie liczba ukrytych stron jest w tym wypadku najważniejsza. Istotniejszy jest fakt, że te zasoby są o wiele wartościowsze niż archiwa "naskórkowego" Internetu. Wynika to z faktu, że o wiele trudniej jest skonstruować serwis WWW generujący dynamiczne witryny, niż stworzyć statyczne strony WWW. Na budowę takich witryn stać jedynie największych - instytucje rządowe, uniwersytety, najbogatsze firmy. A ci z reguły dbają bardzo o wysoki poziom informacji.

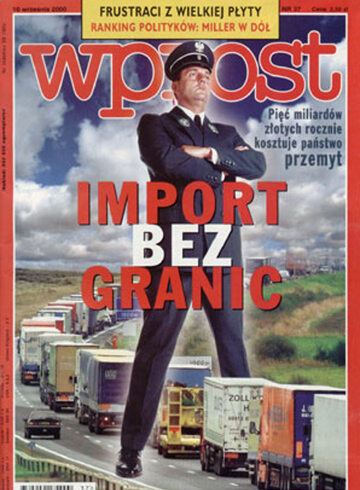

Więcej możesz przeczytać w 37/2000 wydaniu tygodnika Wprost .

Archiwalne wydania tygodnika Wprost dostępne są w specjalnej ofercie WPROST PREMIUM oraz we wszystkich e-kioskach i w aplikacjach mobilnych App Store i Google Play.